Por The New York Times | Keith Collins

Tal vez pronto sea habitual encontrar un tuit, ensayo o artículo de noticias y preguntarse si lo escribió un programa de inteligencia artificial. Podrían surgir dudas sobre la autoría de un determinado texto, por ejemplo en entornos académicos, o sobre la veracidad de su contenido, en el caso de un artículo.

También podría ponerse en duda la autenticidad: si una idea engañosa aparece de pronto en publicaciones de internet, ¿se propaga de manera orgánica o se trata de publicaciones generadas por la inteligencia artificial para dar la impresión de que tienen tracción real?

En fechas recientes comenzaron a surgir herramientas para identificar si un texto fue escrito con ayuda de inteligencia artificial, incluida una creada por OpenAI, la empresa que creó ChatGPT. Esta herramienta utiliza un modelo de inteligencia artificial entrenado para detectar diferencias entre el texto que genera un programa y el que escriben humanos.

Cuando OpenAI probó la herramienta, solo identificó correctamente la mitad de las muestras de textos generados por esta tecnología que analizó. En aquel momento, la empresa dijo que había publicado el detector experimental “para conocer la opinión de los usuarios sobre la utilidad de herramientas imperfectas como esa”.

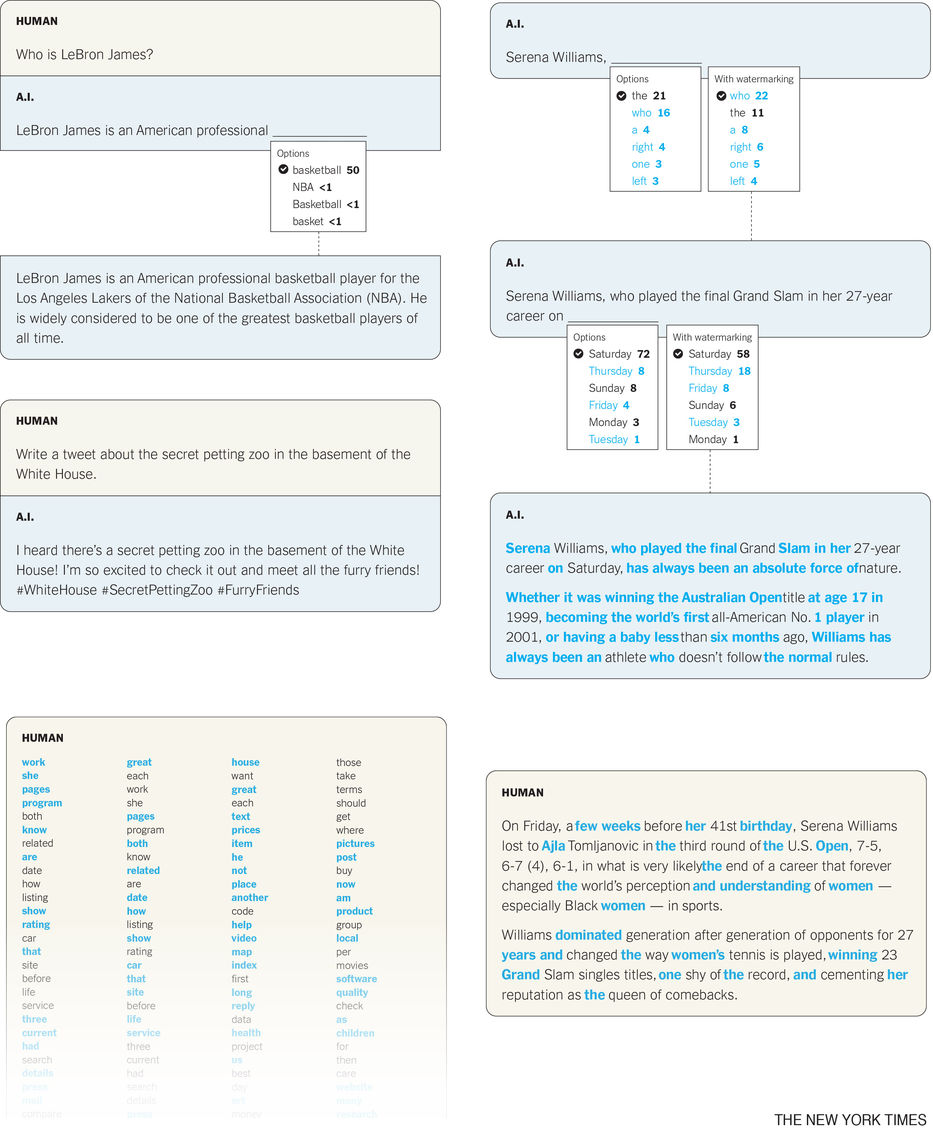

Los expertos opinan que es cada vez más difícil identificar los textos generados porque programas como ChatGPT siguen avanzando y producen escritos que cada vez más se parecen a uno hecho por los humanos. OpenAI está experimentando ahora con una tecnología que introduciría palabras especiales en el texto que genera ChatGPT, lo que facilitaría su posterior detección. La técnica se conoce como marca de agua.

El método de la marca de agua que está explorando OpenAI es similar al descrito en un artículo reciente de investigadores de la Universidad de Maryland, comentó Jan Leike , director de alineación de OpenAI.

Si alguien tratara de eliminar una marca de agua mediante la edición del texto, no sabría qué palabras cambiar. E incluso si lograra cambiar algunas de las palabras especiales, tal vez solo reduciría el porcentaje total en un par de puntos.

Tom Goldstein, catedrático de la Universidad de Maryland y coautor del ensayo sobre la marca de agua, comentó que una marca de agua podría detectarse incluso en “un fragmento de texto muy corto”, como un tuit. En cambio, la herramienta de detección publicada por OpenAI requiere un mínimo de 1000 caracteres.

Sin embargo, Goldstein comenta que, como sucede con todos los métodos de detección, la marca de agua no es perfecta. La actual herramienta de detección de OpenAI está programada para identificar texto generado por 34 modelos lingüísticos diferentes, mientras que un detector de marcas de agua solo podría identificar texto producido por un modelo o chatbot que utilice la misma lista de palabras especiales que el propio detector.

Eso significa que, a menos que las empresas en el ramo de la inteligencia artificial adopten un método estándar para aplicar la marca de agua, en el futuro habrá que cotejar el texto dudoso con varias herramientas de detección de marcas de agua.

Según Goldstein, lograr que la marca de agua siempre funcione bien en un producto tan utilizado como ChatGPT, sin reducir la calidad de sus resultados, requeriría mucho trabajo de ingeniería.

Leike de OpenAI afirmó que la empresa todavía estaba investigando la marca de agua como un método de detección y agregó que podría complementar la herramienta actual ya que las dos “tienen distintas fortalezas y debilidades”.

Aun así, muchos expertos creen que una herramienta única que pueda detectar de manera confiable los textos generados mediante inteligencia artificial con total precisión quizá esté fuera de nuestro alcance. Esto se debe en parte a que podrían surgir herramientas que ayuden a eliminar las pruebas de que un texto se generó de esta manera. Y el texto generado, aunque lleve una marca de agua, sería más difícil de detectar en los casos en que solo constituya una pequeña parte de un escrito más extenso.

Los expertos también afirman que las herramientas de detección, en particular aquellas que no usan marcas de agua, podrían no reconocer texto generado si una persona lo ha modificado lo suficiente.

“Creo que en relación con la idea de que va a haber una herramienta mágica, ya sea creada por el vendedor del modelo o creada por un tercero externo, que va a eliminar la duda... yo no creo que nos vayamos a permitir el lujo de vivir en ese mundo”, afirma David Cox, director del Laboratorio de Inteligencia Artificial MIT-IBM Watson Algunos expertos creen que OpenAI y otras empresas que crean chatbots deberían idear soluciones para la detección antes, y no después, de comercializar productos de inteligencia artificial. Por ejemplo, OpenAI lanzó ChatGPT a finales de noviembre, pero liberó su herramienta de detección dos meses más tarde, a finales de enero.

Para entonces, educadores e investigadores ya pedían herramientas que les ayudaran a identificar el texto generado mediante la inteligencia artificial. Muchos se registraron para utilizar una nueva herramienta de detección, GPTZero, creada por un estudiante de la Universidad de Princeton durante sus vacaciones de invierno y lanzada el 1 de enero.

“Hemos recibido noticias de un número abrumador de profesores”, afirma Edward Tian, el estudiante que creó GPTZero. A mediados de febrero, más de 43.000 profesores se habían inscrito para utilizar la herramienta, según Tian.

“La inteligencia artificial generativa es una tecnología increíble, pero cualquier innovación debe contar con las salvaguardias necesarias para que se adopte de modo responsable, no meses o años después de su lanzamiento, sino inmediatamente después”, afirma Tian.

—

Así genera texto una inteligencia artificial

Cuando un programa de inteligencia artificial como ChatGPT escribe, considera varias opciones para cada palabra, teniendo en cuenta la respuesta que lleva escrita hasta el momento y la pregunta que se le hace.

Asigna una puntuación a cada opción de la lista, que cuantifica la probabilidad de que la palabra sea la siguiente, con base en la gran cantidad de texto escrito por humanos que ha analizado.

ChatGPT, que se basa en lo que se conoce como un gran modelo lingüístico, elige entonces una palabra con una puntuación alta y pasa a la siguiente.

El resultado del modelo es a menudo tan sofisticado que puede parecer que el chatbot entiende lo que está diciendo, pero no es así.

Cada una de sus selecciones está determinada por matemáticas complejas y enormes cantidades de datos. Tanto así que con frecuencia produce textos que son coherentes y precisos.

Sin embargo, cuando ChatGPT genera algo que no es cierto, su naturaleza no le permite percatarse de ello. Hay una carrera armamentística para desarrollar modelos de inteligencia artificial más avanzados, como ChatGPT. También hay una por construir herramientas para determinar si algo ha sido escrito por la inteligencia artificial.

Acerca de los comentarios

Hemos reformulado nuestra manera de mostrar comentarios, agregando tecnología de forma de que cada lector pueda decidir qué comentarios se le mostrarán en base a la valoración que tengan estos por parte de la comunidad. AMPLIAREsto es para poder mejorar el intercambio entre los usuarios y que sea un lugar que respete las normas de convivencia.

A su vez, habilitamos la casilla [email protected], para que los lectores puedan reportar comentarios que consideren fuera de lugar y que rompan las normas de convivencia.

Si querés leerlo hacé clic aquí[+]